Si vous lisez ces lignes sur un smartphone dernier cri ou un MacBook Pro survitaminé, vous utilisez, au fond, une technologie qui date de la fin de la Seconde Guerre mondiale. C'est fou quand on y pense. On change de processeur tous les trois ans, on double la RAM, on passe à l'intelligence artificielle, mais la structure fondamentale, le squelette de la machine, reste l'architecture de von Neumann.

Tout a commencé avec un rapport de 101 pages intitulé "First Draft of a Report on the EDVAC", publié en 1945. John von Neumann, un mathématicien austro-hongrois de génie (le genre de type qui pouvait multiplier des nombres à huit chiffres de tête pour s'amuser), n'est pas le seul inventeur du concept. Il a travaillé avec J. Presper Eckert et John Mauchly sur l'ENIAC, mais c'est son nom qui est resté. Pourquoi ? Parce qu'il a formalisé l'idée révolutionnaire que les données et les programmes devaient être stockés au même endroit.

Avant ça, programmer un ordinateur, c’était un cauchemar physique. Il fallait littéralement recâbler la machine, déplacer des fiches, actionner des commutateurs. L’architecture de von Neumann a tout changé en introduisant le concept de "programme enregistré".

Les entrailles de la bête : comment ça marche vraiment ?

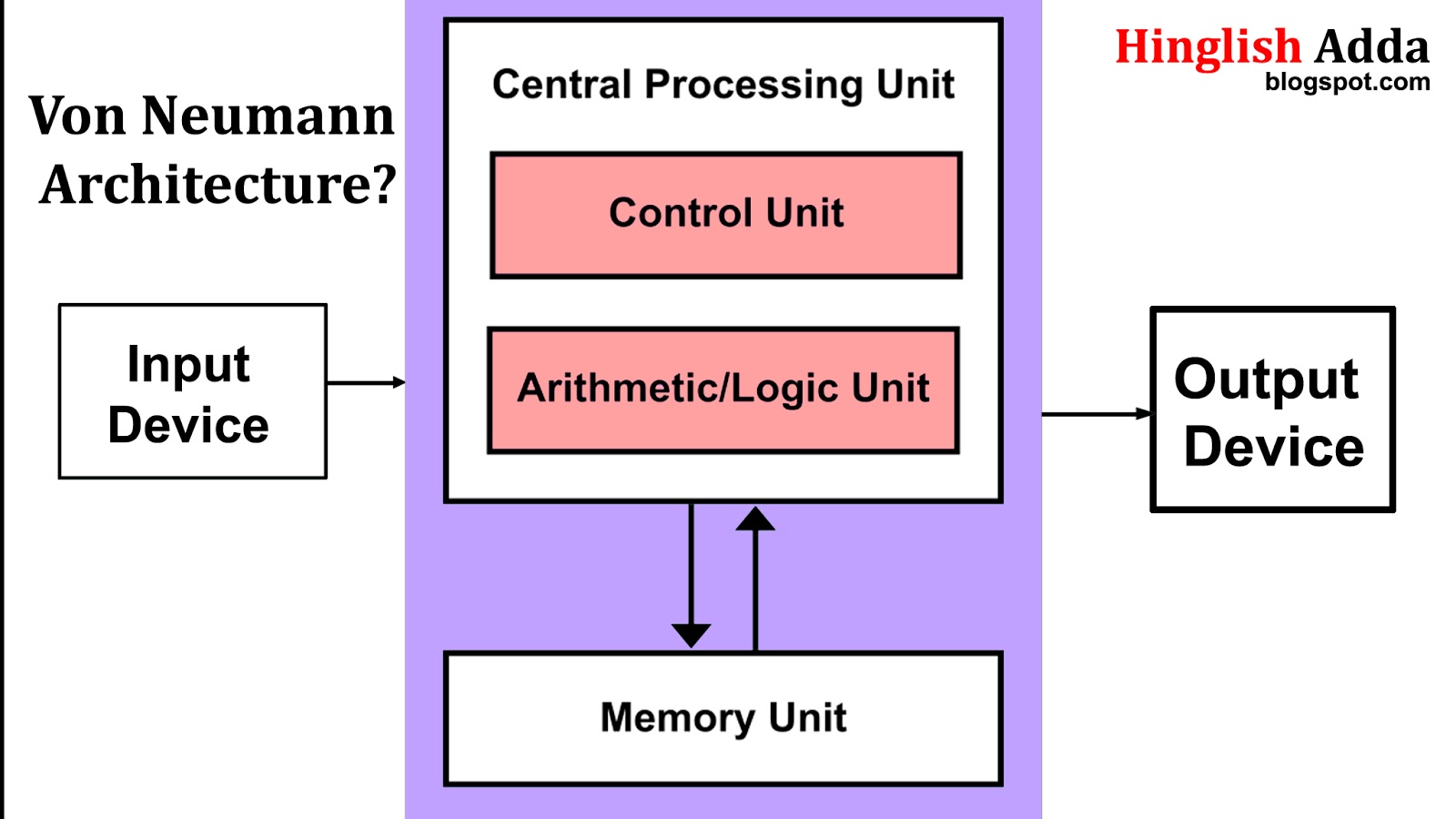

Fondamentalement, une machine de von Neumann repose sur quatre blocs principaux. Imaginez une cuisine. Vous avez le plan de travail, le garde-manger, le chef et les instructions de la recette.

- L'unité centrale de traitement (CPU) : C'est le cerveau. Il contient l'unité arithmétique et logique (ALU), qui fait les calculs (des additions, des comparaisons), et l'unité de contrôle qui dirige le trafic.

- La mémoire vive (RAM) : C’est là que tout se passe. Contrairement aux machines précédentes, l'architecture de von Neumann stocke ici à la fois les données (vos photos, vos textes) et les instructions (le code de votre navigateur web).

- Les interfaces d'entrée et de sortie : Votre clavier, votre souris, votre écran. C'est le pont avec le monde des humains.

- Le bus : Le système de communication. C'est le fil électrique qui transporte les informations entre la mémoire et le processeur.

C'est simple. C'est élégant. Et c'est exactement là que le bât blesse.

📖 Related: Savannah Weather Radar: What Most People Get Wrong

Le fameux "Goulot d'étranglement" (Von Neumann Bottleneck)

Vous avez sans doute déjà ressenti cette frustration : votre processeur tourne à 4 GHz, vous avez un SSD ultra-rapide, et pourtant, l'ordinateur semble ramer sur une tâche complexe. Bienvenue dans le goulot d'étranglement de von Neumann.

Le problème est structurel. Comme les données et les instructions partagent le même chemin (le bus) pour aller de la mémoire au processeur, ils ne peuvent pas passer en même temps. C'est comme essayer de faire passer une armée entière par une porte de garage étroite. Peu importe la vitesse à laquelle les soldats courent à l'extérieur ou la rapidité avec laquelle ils travaillent à l'intérieur, la porte limite tout.

John Backus, le créateur du langage Fortran, a popularisé ce terme en 1977. Il expliquait que ce va-et-vient constant entre le CPU et la mémoire consomme une énergie folle et limite la vitesse de calcul. On a essayé de tricher. On a inventé la mémoire cache (L1, L2, L3) pour garder les données souvent utilisées juste à côté du processeur. On a créé le "pipelining" pour anticiper les prochaines instructions. Mais le fond du problème reste : le CPU attend la mémoire. Toujours.

L'alternative : L'architecture Harvard

Il existe une autre voie, souvent utilisée dans les microcontrôleurs (comme ceux de votre lave-linge ou de votre voiture). L'architecture Harvard sépare physiquement les chemins pour les instructions et les données. Deux bus, deux mémoires. C’est plus rapide pour certaines tâches spécifiques, mais c'est beaucoup plus complexe et coûteux à fabriquer pour un ordinateur généraliste. Aujourd'hui, on utilise souvent un mix des deux : une architecture de von Neumann pour le système global, mais avec des caches séparés (Harvard interne) au sein même du processeur.

👉 See also: Project Liberty Explained: Why Frank McCourt Wants to Buy TikTok and Fix the Internet

Est-ce que c'est bientôt la fin ?

Honnêtement, on arrive aux limites physiques. Avec l'explosion de l'IA et du Deep Learning, le modèle de von Neumann commence à montrer ses rides. Les réseaux de neurones artificiels nécessitent de brasser des pétaoctets de données. Faire faire des allers-retours à ces données entre la RAM et le processeur est devenu une hérésie écologique et technique.

C'est là qu'entrent en scène les processeurs neuromorphiques ou le "In-Memory Computing". L'idée ? On ne déplace plus la donnée vers le calcul, on fait le calcul directement là où se trouve la donnée. On s'inspire du cerveau humain. Dans votre tête, il n'y a pas un processeur d'un côté et un disque dur de l'autre. Les neurones font les deux.

Des entreprises comme IBM avec la puce TrueNorth ou Intel avec Loihi explorent ces pistes. Mais ne jetez pas votre PC tout de suite. Le code mondial, de Windows à Linux en passant par vos applications bancaires, est écrit pour des machines de von Neumann. Changer d'architecture, c'est comme demander à tout le monde de parler une langue qui n'existe pas encore.

Pourquoi vous devriez vous y intéresser

Comprendre l'architecture de von Neumann, ce n'est pas juste un cours d'histoire poussiéreux. C'est comprendre pourquoi la gestion de la mémoire est le nerf de la guerre en programmation. C'est comprendre pourquoi un processeur avec plus de cœurs n'est pas forcément plus rapide si le bus de données ne suit pas.

✨ Don't miss: Play Video Live Viral: Why Your Streams Keep Flopping and How to Fix It

Voici quelques réalités concrètes à garder en tête :

- La RAM est plus importante que vous ne le croyez : Ce n'est pas juste une question de quantité, mais de vitesse de communication (latence).

- L'IA change la donne : Si vous travaillez dans la tech, sachez que les architectures vont diverger. On aura des machines "classiques" pour la bureautique et des accélérateurs tensoriels (TPU) totalement différents pour l'IA.

- Le code efficace gère la localité : Un bon développeur écrit son code de manière à ce que les données nécessaires soient regroupées, évitant ainsi au CPU de multiplier les voyages vers la mémoire principale.

L'architecture de von Neumann est sans doute l'une des inventions les plus durables de l'histoire moderne. Elle a survécu au passage des tubes à vide aux transistors, puis aux circuits intégrés. Elle survivra probablement encore quelques décennies, tant sa simplicité logique est puissante.

Pour aller plus loin, vous pouvez explorer les travaux originaux de 1945, souvent disponibles en accès libre sur les archives universitaires comme celles de Stanford. Regardez aussi du côté de l'architecture RISC-V, qui simplifie le jeu d'instructions tout en restant fidèle au modèle de von Neumann, offrant une flexibilité inédite pour les concepteurs de puces modernes. La prochaine fois que votre ordinateur ralentit, ne blâmez pas seulement votre processeur ; ayez une petite pensée pour ce vieux goulot d'étranglement qui nous suit depuis près d'un siècle.

Actions à entreprendre pour approfondir le sujet :

- Analyser votre système : Utilisez des outils comme CPU-Z (Windows) ou l'Utilitaire de disque (Mac) pour visualiser la hiérarchie de votre mémoire cache et comprendre comment votre machine tente de contourner le goulot d'étranglement.

- Étudier l'In-Memory Computing : Si vous êtes développeur, renseignez-vous sur les bases de données vectorielles et les architectures de calcul en mémoire (comme SAP HANA ou Redis) qui optimisent la performance en réduisant les déplacements de données.

- Comparer les ISA : Comparez les jeux d'instructions x86 (complexe) et ARM (plus proche de la philosophie von Neumann simplifiée) pour voir comment l'efficacité énergétique en dépend.