Internet ha cambiado. No es una frase hecha, es una realidad técnica. Si hace cinco años nos hubieran dicho que una sola imagen estática podría convertirse en un clip de video explícito en menos de sesenta segundos, habríamos pensado en efectos especiales de Hollywood. Hoy, la búsqueda de video haciendo porno IA con foto es una de las tendencias más oscuras y complejas de la red. No se trata solo de tecnología; se trata de consentimiento, de leyes que no corren tan rápido como el código y de una industria que está canibalizando la privacidad.

Es una locura. Literalmente puedes tomar una selfie de Instagram y, mediante redes generativas adversarias (GAN) o modelos de difusión, ver cómo esa persona cobra vida en situaciones que nunca ocurrieron. La tecnología detrás de esto, a menudo llamada "Deepfake", ha democratizado la creación de contenido sintético. Pero esa democratización tiene un precio altísimo.

El motor bajo el capó: Cómo funciona un video haciendo porno IA con foto

No es magia, aunque lo parezca. Básicamente, estos sistemas utilizan una arquitectura de aprendizaje profundo. El software analiza los rasgos faciales de la foto: la distancia entre los ojos, la forma de la mandíbula, la curvatura de los labios. Luego, "mapea" esos rasgos sobre un video base, también conocido como target video.

Hay herramientas como DeepFaceLab o aplicaciones basadas en la nube que hacen el trabajo sucio. Honestamente, la mayoría de la gente no sabe que lo que están viendo es una transferencia de textura. El modelo de IA no "entiende" lo que está creando; simplemente predice dónde debería estar cada píxel para que coincida con el movimiento del video original. Es pura estadística visual.

La evolución ha sido brutal. Al principio, los resultados eran borrosos. Los ojos no parpadeaban. Ahora, con los modelos de difusión estables, los reflejos en las pupilas y el movimiento del cabello son casi perfectos. Es aterradoramente realista.

El vacío legal y el impacto real en las víctimas

Aquí es donde la cosa se pone seria. La mayoría de los países todavía están rascándose la cabeza sobre cómo legislar esto. En España, por ejemplo, el Código Penal ya empieza a contemplar estos actos como delitos contra la intimidad, incluso si la imagen es falsa. Porque, seamos sinceros, el daño reputacional es idéntico.

🔗 Read more: EU DMA Enforcement News Today: Why the "Consent or Pay" Wars Are Just Getting Started

No estamos hablando solo de celebridades. Ese es el mayor error. El ciudadano de a pie, estudiantes de secundaria, ex parejas buscando venganza... ellos son los objetivos principales. Un video haciendo porno IA con foto puede destruir una carrera profesional en una tarde. Lo que antes requería habilidades avanzadas de edición de video, ahora se hace con un bot de Telegram.

Organizaciones como Sensity AI han reportado que más del 90% de los deepfakes en línea son de contenido no consentido. Eso no es "arte generado por IA", es una herramienta de acoso masivo. La gente sube fotos a redes sociales sin pensar que ese píxel puede ser usado en su contra mañana mismo.

¿Se puede detectar?

A veces sí, a veces no. Kinda. Si te fijas mucho, puedes notar que el borde de la cara no encaja perfectamente con el cuello. O quizás la iluminación de la cara no coincide con el fondo. Pero seamos realistas: la mayoría de la gente consume contenido de forma rápida en sus teléfonos. Nadie se detiene a analizar la tasa de refresco de los párpados.

Investigadores de universidades como Buffalo están trabajando en algoritmos que detectan estas anomalías, pero es una carrera armamentista. Por cada detector, sale una nueva versión de IA que corrige ese error específico. Es el juego del gato y el ratón en versión digital.

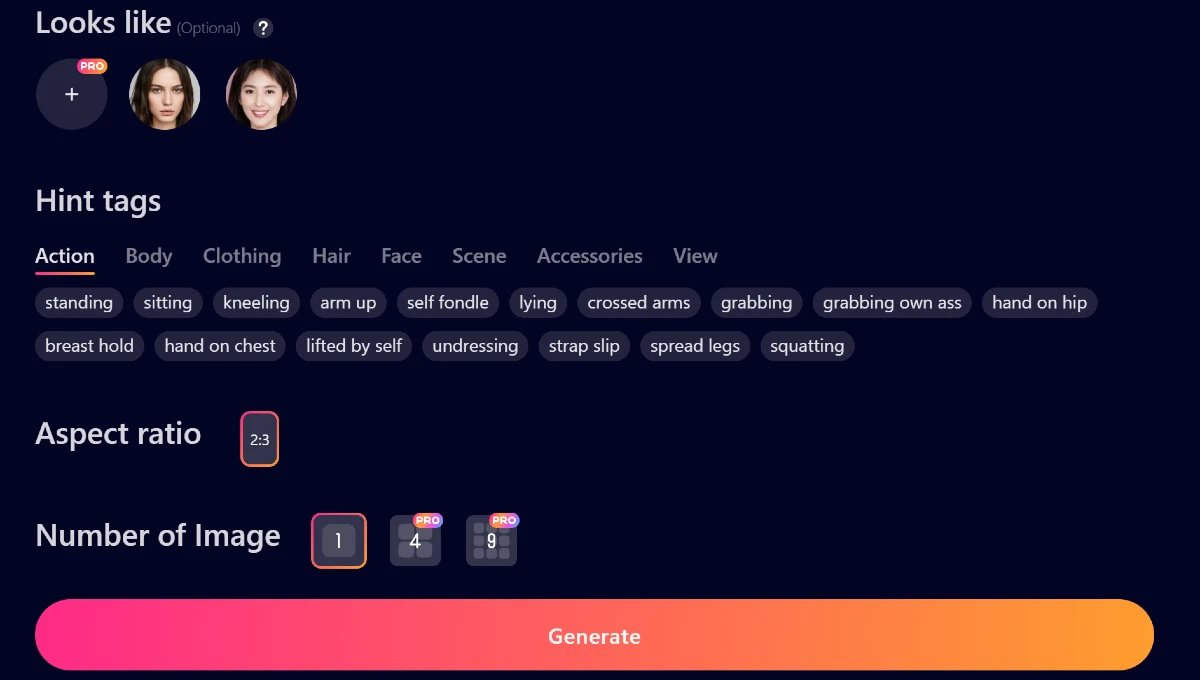

Las herramientas que alimentan el ecosistema

No voy a dar nombres específicos de sitios que promueven el abuso, pero la infraestructura es obvia. Existen plataformas que funcionan bajo suscripción donde el usuario solo tiene que arrastrar y soltar una imagen. Es una interfaz de usuario diseñada para que un niño de diez años pueda usarla.

💡 You might also like: Apple Watch Digital Face: Why Your Screen Layout Is Probably Killing Your Battery (And How To Fix It)

La computación en la nube ha facilitado esto. Antes necesitabas una tarjeta gráfica de 2.000 dólares para procesar un video. Ahora, los servidores remotos hacen el trabajo pesado por unos pocos créditos. Es un modelo de negocio basado en la vulnerabilidad ajena.

Incluso empresas legítimas de IA como OpenAI o Google tienen filtros estrictos, pero el código abierto (Open Source) es otra historia. Modelos como Stable Diffusion pueden ser modificados por cualquier persona con conocimientos técnicos para eliminar los "seguros" éticos. Una vez que el genio sale de la botella, no hay forma de volver a meterlo.

El papel de las redes sociales

Instagram, TikTok y X (antes Twitter) están en una posición difícil. Intentan banear este contenido, pero se suben miles de videos por segundo. La IA de moderación de contenido a menudo falla porque el video parece "real". No detecta que la cara es un injerto digital.

Es un problema de escala. Básicamente, estamos pidiendo a las máquinas que vigilen a otras máquinas. Y las máquinas que crean suelen ir un paso por delante de las que vigilan.

Qué hacer si eres víctima de un deepfake

Si alguna vez te encuentras con un video haciendo porno IA con foto donde apareces tú o alguien que conoces, no entres en pánico, pero actúa rápido. La evidencia digital es volátil.

📖 Related: TV Wall Mounts 75 Inch: What Most People Get Wrong Before Drilling

- Documenta todo: Capturas de pantalla, URLs, nombres de usuario. No borres nada antes de tener pruebas.

- Reporta a la plataforma: Todas las grandes redes tienen canales específicos para contenido íntimo no consentido.

- Denuncia ante las autoridades: En muchos países, la creación de este contenido ya es un delito penal.

- Contacta con especialistas: Organizaciones como StopNCII.org ayudan a las víctimas a eliminar este contenido de los motores de búsqueda mediante hashes digitales.

La prevención es complicada. En un mundo donde nuestra cara es nuestra identidad pública, dejar de subir fotos no es una opción para muchos. Pero sí podemos ser más conscientes de con quién compartimos nuestro contenido y qué tan privadas son nuestras cuentas.

Reflexión sobre el futuro de la identidad visual

Estamos entrando en la era de la "post-verdad visual". Pronto, un video no servirá como prueba de nada. Esto tiene implicaciones profundas, no solo en lo personal, sino en lo político y social. Si no podemos creer en lo que vemos, ¿en qué podemos creer?

La tecnología de video haciendo porno IA con foto es solo la punta del iceberg de un cambio cultural masivo. La identidad se está volviendo líquida. Lo que antes era una prueba irrefutable —"estuve allí, aquí está el video"— ahora es solo una posibilidad entre muchas.

La solución no vendrá solo de la tecnología. Necesitamos una educación digital robusta. Aprender a dudar es la herramienta de supervivencia más importante en 2026. No se trata de ser paranoicos, sino de entender que el mapa digital ya no representa fielmente el territorio físico.

Pasos prácticos para proteger tu presencia digital

La mejor defensa es una buena gestión de los datos. No vas a desaparecer de internet, pero puedes hacer que sea más difícil para los bots recolectar tu información.

- Privacidad en redes: Cambia tus perfiles a modo privado si no necesitas una exposición pública por trabajo. Esto limita quién puede descargar tus fotos para usarlas en modelos de IA.

- Uso de marcas de agua: Aunque no es infalible, poner marcas de agua sutiles en tus fotos puede dificultar que los algoritmos de mapeo facial funcionen correctamente.

- Conciencia sobre el contenido: Piensa dos veces antes de subir fotos en alta resolución con el rostro totalmente despejado y de frente. Son el "alimento" perfecto para estas redes neuronales.

- Google Alerts: Configura alertas con tu nombre para monitorear si aparece contenido nuevo indexado en la web que pueda estar relacionado contigo.

- Búsqueda inversa de imágenes: Hazlo periódicamente. Herramientas como PimEyes (con precaución ética) o Google Lens pueden decirte dónde más está circulando tu cara.

La responsabilidad también recae en los desarrolladores. La implementación de marcas de agua invisibles o "meta-datos de procedencia" en las imágenes generadas por IA es un paso necesario. Si cada archivo creado por una IA llevara una firma digital obligatoria, sería mucho más fácil para los navegadores y redes sociales identificar y bloquear contenido malintencionado de forma automática.

Al final, la tecnología es una herramienta neutral, pero el uso que le estamos dando a la generación de video mediante fotos está cruzando líneas éticas que nunca antes habíamos tenido que dibujar. Mantenerse informado y alerta es la única forma de navegar este nuevo ecosistema sin perder el control sobre nuestra propia imagen.